仅需约主流模型2%的数据量,就能在多项语言理解和推理任务中达到媲美众多主流模型的性能。近日,中国科学院自动化研究所李国齐、徐波团队与沐曦MetaX合作,成功研发出类脑脉冲大模型“瞬悉1.0”。

该模型基于“内生复杂性”理论构建,在国产GPU平台上完成了全流程训练与推理,显著提升了大模型高效处理极长文本或数据序列的效率和速度,展示了构建国产自主可控的新型(非Transformer)大模型架构生态的可行性。

与前主流大模型架构(Transformer架构)不同,“瞬悉1.0” (SpikingBrain-1.0)借鉴大脑神经元内部工作机制,清晰地展示了一条不断提升模型复杂度和性能的新型可行路径。

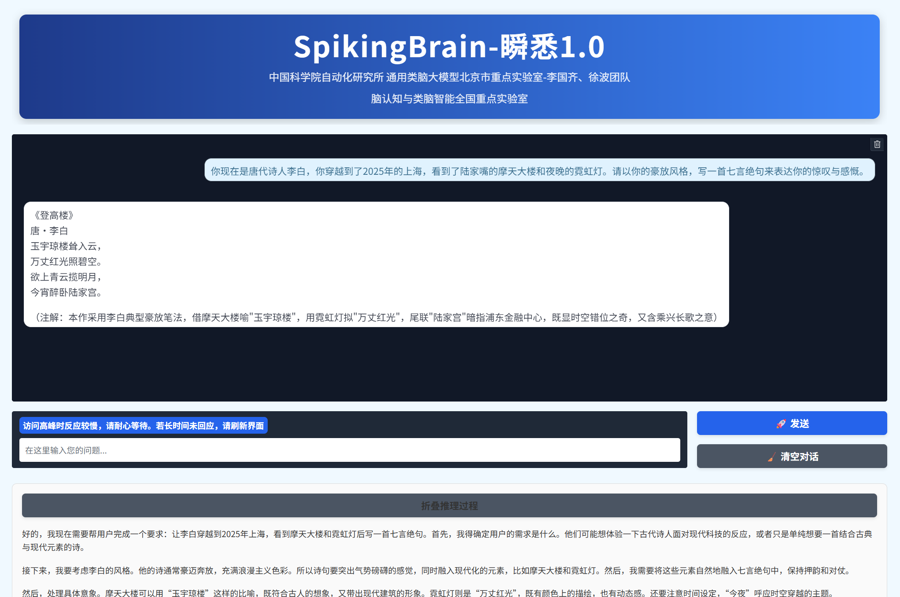

“瞬悉1.0”。受访单位提供

“瞬悉1.0”。受访单位提供

这是我国首次提出大规模类脑线性基础模型架构,并首次在国产GPU算力集群上构建类脑脉冲大模型的训练和推理框架。其超长序列处理能力在法律/医学文档分析、复杂多智能体模拟、高能粒子物理实验、DNA序列分析、分子动力学轨迹等超长序列任务建模场景中具有显著的潜在效率优势。

本次发布的大模型为新一代人工智能发展提供了非Transformer架构的新技术路线,并将启迪更低功耗的下一代神经形态计算理论和芯片设计。

天创优配提示:文章来自网络,不代表本站观点。